Создатели ChatGPT представили новую языковую модель GPT-4, способную обрабатывать изображения

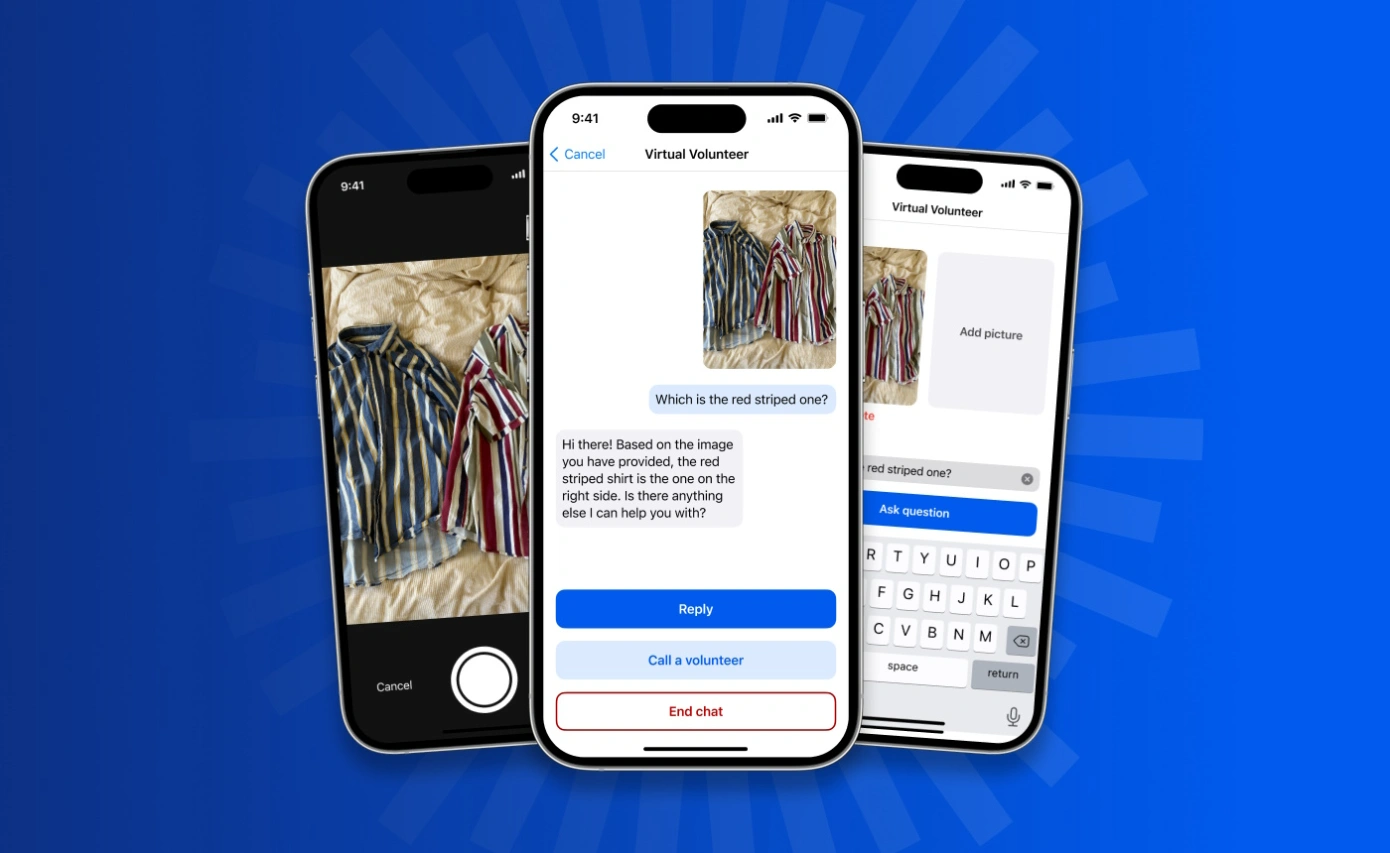

Американская компания OpenAI представила GPT-4 — новую версию языковой модели с искусственным интеллектом, которая может понимать не только текст, но и изображения. Об этом сообщается на сайте IT-гиганта.

По словам разработчиков, GPT-4 более креативна и «надежна», чем предыдущая версия, GPT-3.5. Новая языковая модель обрабатывает текст и изображения, но на выходе выдает только текстовый ответ, то есть картинки она не генерирует.

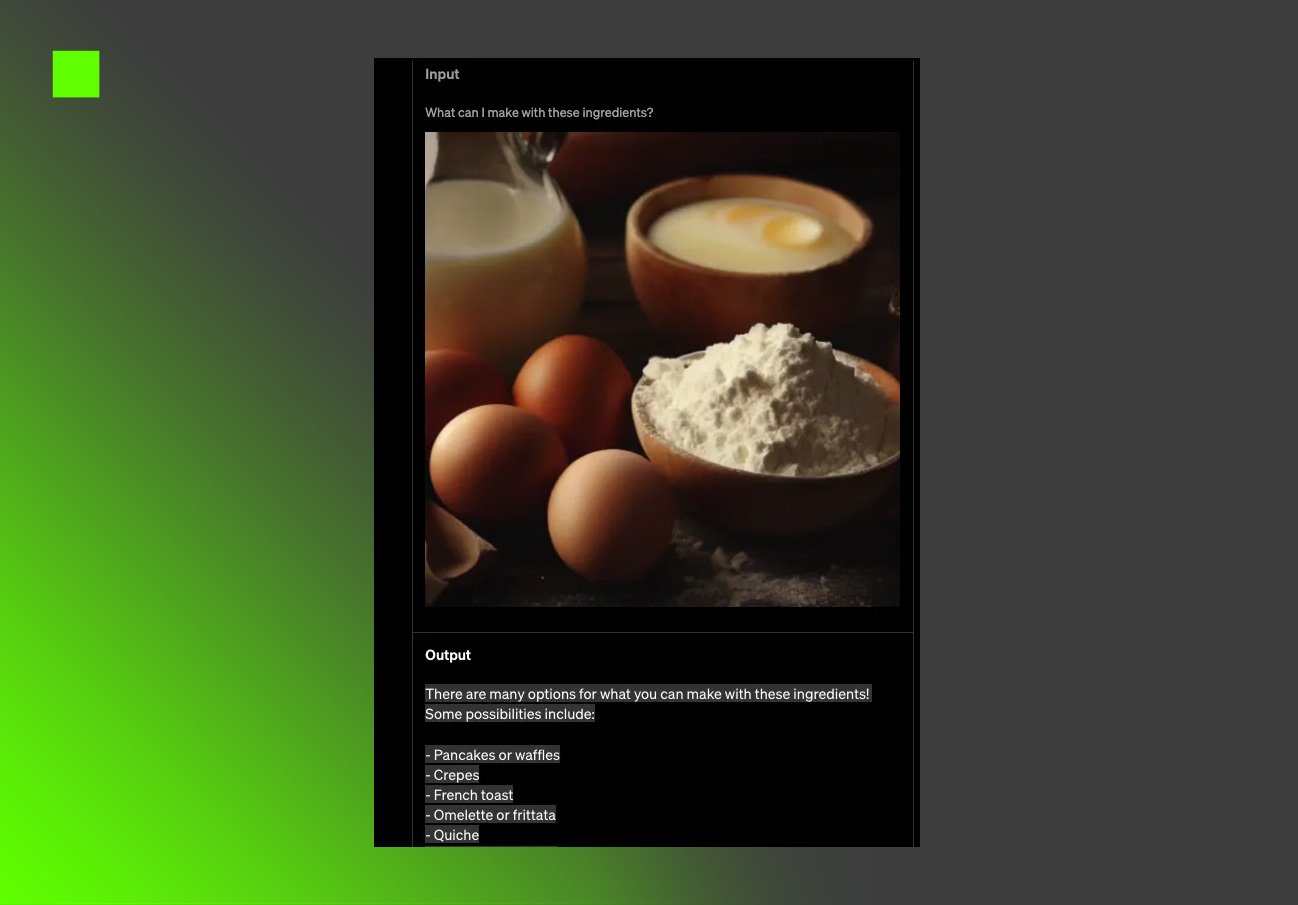

К примеру, GPT-4 может рассказать о содержимом холодильника по его фотографии и предложить рецепты из продемонстрированных ей продуктов, отмечает TechCrunch. Однако функция обработки изображений пока недоступна широкому кругу пользователей.

При обычной беседе разница между GPT-3.5 и GPT-4 может быть весьма заметной, но преимущества новой модели очевидны при выполнении более сложных задач. Так, прогресс в производительности GPT-4 виден по тому, как она сдает тесты и экзамены, предназначенные для людей, набирая 90% и выше из возможных 100%. В качестве примера разработчики приводят экзамен на адвоката, за который GPT-4 получила оценку, сопоставимую с результатами 10% лучших экзаменуемых среди людей.

GPT-4 уже используется в ChatGPT, а также в обновленном браузере Bing от Microsoft. Новой языковой моделью пока могут воспользоваться только владельцы подписки ChatGPT Plus, а также тестировщики.